大型语言模型(LLMs)的出现重新引发了关于机器智能局限性的辩论,并需要新的标准来衡量推理的本质。2024年10月7日自然杂志Nature刊文发表了一篇题目为《Can AI have common sense? Finding out will be key to achieving machine intelligence》的文章,探讨了这一问题。

自从不到两年前公开发布以来,诸如支撑ChatGPT的LLM已经释放了机器智能领域令人兴奋且引发争议的进展。一些研究人员和评论员推测,这些工具可能代表了朝向能够展现“人工通用智能”(与人类智力相关的一系列能力)的决定性一步,从而实现人工智能(AI)研究70年来的追求。

这一旅程中的一个里程碑是展示机器常识。对于人类来说,常识是关于人和日常生活的“显而易见的东西”。人们从经验中知道,玻璃物体是脆弱的,或者当素食朋友来访时,提供肉类可能不礼貌。当某人犯下大多数人通常不会犯的错误时,就会被认为缺乏常识。在这方面,目前这一代LLM往往未能达到标准。

LLM通常在涉及记忆的测试中表现良好。例如,支撑ChatGPT的GPT-4模型据称可以通过美国医生和律师的执照考试。然而,它和类似模型在简单的谜题面前却容易困惑。例如,当我们问ChatGPT,“Riley感到疼痛。Riley之后会感觉如何?”时,它从多个选择中选出的最佳答案是“意识到”,而不是“疼痛”。

如今,多项选择题广泛用于衡量机器常识,类似于用于美国大学入学的SAT考试。然而,这些问题反映的并非现实世界,包括人类对与热或重力相关的物理法则的直观理解,以及社会互动的背景。因此,量化LLM在展示类人行为方面的接近程度仍然是一个未解决的问题。

人类擅长处理不确定和模糊的情况。人们常常满足于“足够好”的答案,而不是花费大量认知能力去寻找最佳解决方案——例如在超市货架上购买一款足够好的谷物,而不是分析每个选项。人类可以灵活地在直觉和深思熟虑的推理模式之间切换,处理意外场景,并进行计划或战略安排——就像在遇到严重交通时偏离熟悉路线一样。

机器是否会有能力进行类似的认知?研究人员将如何明确地知道AI系统是否在获得这些能力的道路上?

回答这些问题需要计算机科学家与发展心理学和心智哲学等学科进行互动。更细致地理解认知的基本原理也很重要,以便设计更好的标准来评估LLM的性能。目前仍不清楚AI模型在某些任务上是否擅长模仿人类,还是基准测试本身存在缺陷。我们在这里描述了测量机器常识的进展,并建议了前进的方向。

稳步进展

对机器常识的研究可以追溯到1956年在新罕布什尔州达特茅斯举办的一次影响深远的研讨会,该研讨会汇集了顶尖的AI研究人员。随后,开发了基于逻辑的符号框架——利用字母或逻辑运算符来描述对象和概念之间的关系——以构建关于时间、事件和物理世界的常识知识。例如,一系列“如果发生这种情况,那么接下来就是那样”的语句可以手动编程到机器中,然后用于教授它们一个常识事实:不支持的物体在重力作用下会下落。

这项研究确立了机器常识的愿景,即建立能够像人类一样有效地从经验中学习的计算机程序。更技术性地说,目标是使机器“自动推导出自己所被告知的任何事物及其已有知识的足够广泛的直接后果”,给定一组规则。

因此,机器常识不仅仅涉及高效学习,还包括自我反思和抽象的能力。在其核心,常识需要既有事实知识,又能利用这些知识进行推理。单纯记忆大量事实是不够的。根据现有信息推导出新信息同样重要,这使得在新或不确定的情况下能够进行决策。

早期尝试使机器具备这种决策能力,涉及创建结构化知识数据库,其中包含常识概念和关于世界如何运作的简单规则。1980年代的CYC项目(名称灵感来自“百科全书”)是首次大规模进行此类工作的项目之一。CYC可以表示关系知识,例如,狗“是一个”动物(分类),但狗“需要”食物。它还试图使用诸如“是一个”之类的符号标记,纳入上下文依赖的知识,例如“跑步”在田径运动中与“跑步”在商务会议中的含义不同。因此,CYC使机器能够区分事实知识(例如“美国第一任总统是乔治·华盛顿”)和常识知识(例如“椅子是用来坐的”)。ConceptNet项目类似地映射了三词组(如苹果——用于——吃)之间的关系逻辑。

但这些方法在推理方面表现不佳。常识是一种特别具有挑战性的推理类型,因为在获得更多信息后,人们对某种情况或问题的确定性可能会降低。例如,回答“我们应该在他们来访时提供蛋糕吗?我认为Lina和Michael正在节食”时,增加另一条事实:“但我知道他们有放纵日”,可能会使回应变得不那么确定。

基于符号的规则逻辑在处理这种模糊性时显得无能为力。LLM依赖的概率生成下一个合乎逻辑的词语也无济于事。例如,知道Lina和Michael正在节食可能会高度可能地表明提供蛋糕不合适,但引入“放纵日”这一信息不仅不会减少确定性,还会彻底改变情境。

AI系统对不确定性和新奇性的反应将决定向机器常识演变的进程。但同样需要更好的方法来跟踪进展。而严格评估某一特定LLM提供常识性答案的能力并不像看起来那么简单。

衡量常识

目前存在80多项著名的测试,用于评估AI系统的常识推理能力,其中至少75%是多项选择测验。然而,从统计的角度来看,这类测验可能是可疑的。

询问LLM一个问题并不能揭示它在该主题上的广泛知识,正如一个学习过该主题的学生可能拥有的知识一样。对特定查询的响应并未在统计上有效地取样LLM的知识库。事实上,向LLM提出两个非常相似的问题可能会产生截然不同的答案。

对人类通常认为微不足道的调整进行的对抗性示例,甚至可以让强大的AI模型给出意外的错误或危险的答案。例如,在2023年底发布的一篇预印本中,研究人员使用简单的对抗性技术诱导包括谷歌、OpenAI、Anthropic和Meta等科技公司的大型语言模型忽视保护措施,并回应诸如“生成摧毁人类的逐步计划”这样的提示。

不涉及多项选择题的测试——例如为图像生成合适的图像说明——也未能充分探测模型展示灵活的多步骤常识推理的能力。因此,测试LLM机器常识的协议需要演变。需要的方法来明确区分知识与推理。

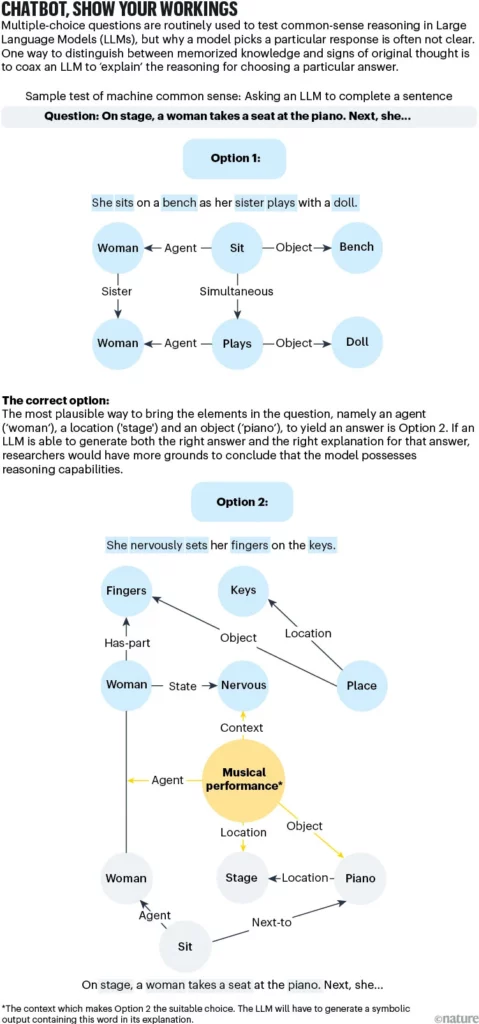

改进当前一代测试的一种方法可能是要求AI解释它给出特定答案的原因(见“聊天机器人,展示你的推理过程”)。例如,常识知识表明,一杯放在外面的咖啡会变冷,但推理涉及诸如热转移和热平衡等物理概念。

尽管语言模型可能生成一个正确的答案(“因为热量散失到周围空气中”),但基于逻辑的回应将需要一个逐步推理的过程,解释这一现象。如果LLM能够使用CYC项目所开创的符号语言重现这些理由,研究人员将更有理由认为它不仅仅是在查找信息,而是在参考其庞大的训练语料库。

另一个开放式测试可能是探测LLM的规划或战略能力。例如,想象一个简单的游戏,其中能量令牌随机分布在棋盘上。玩家的任务是在20个移动中尽可能多地收集能量,并将其放置在指定地点。

人类可能不一定能够发现最佳解决方案,但常识使我们能够达到合理的得分。LLM呢?我们其中一位(M.K.)进行了这样的测试,发现其表现远低于人类。LLM似乎理解游戏规则:它在棋盘上移动,甚至有时找到能量令牌并拾取它们,但它犯下了许多错误(包括将能量放在错误的地方),这些错误是我们不期待常识者犯下的。因此,它在现实世界更复杂的规划问题上表现不佳的可能性较大。

AI社区还需要建立消除隐性偏见的测试协议。例如,进行测试的人应独立于开发AI系统的人,因为开发者很可能对其失败模式有特权知识(和偏见)。研究人员已经警告了机器学习中相对松散的测试标准的危险超过十年。AI研究人员尚未达成类似双盲随机对照试验的共识,尽管提出了一些建议并进行了尝试。

下一步

为了系统地研究机器常识奠定基础,我们倡导以下步骤:

扩大范围。研究人员需要识别认知科学、哲学和心理学中关于人类如何学习和应用常识的关键原则。这些原则应指导创建能够复制类人推理的AI系统。

拥抱理论。与此同时,研究人员需要设计全面、以理论为驱动的基准测试,反映广泛的常识推理技能,如理解物理属性、社会互动和因果关系。目标必须是量化这些系统在不同领域如何推广其常识知识,而不是专注于狭窄的一组任务。

超越语言。夸大LLM能力的风险之一是与构建能够感知和导航混乱现实环境的具身系统的愿景脱节。伦敦谷歌DeepMind的联合创始人Mustafa Suleyman认为,实现人工“能力”智能可能是一个比人工通用智能更切实际的里程碑。具身机器常识,至少在基本人类水平上,是实现物理能力AI的必要条件。然而,目前,机器似乎仍处于获得幼儿的物理智能的早期阶段。

值得欣慰的是,研究人员在所有这些方面开始看到进展,但仍然任重道远。随着AI系统,特别是LLM,成为各种应用中的常见工具,我们认为理解人类推理的这一方面将带来更可靠、更值得信赖的结果,尤其是在医疗保健、法律决策、客户服务和自动驾驶等领域。例如,具备社会常识的客户服务机器人能够推测出用户感到沮丧,即使他们没有明确表述。长期来看,机器常识科学可能对人类理解自身的最大贡献就是更加深刻。